POUR EN FINIR AVEC L'ORDRE ET LE CHAOS / Susskind ou l'entropie des trous noirs

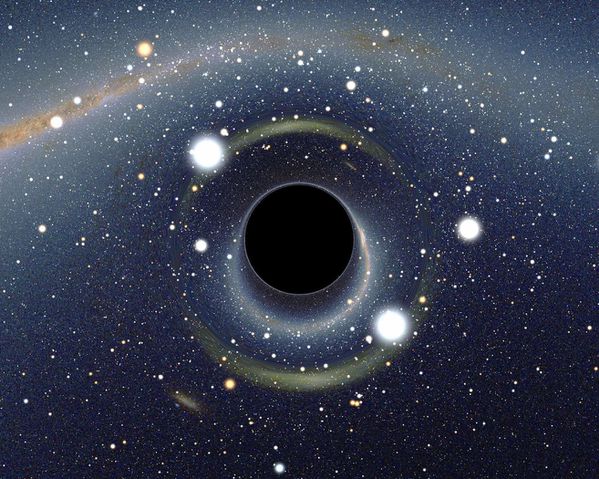

Le physicien libéral Susskind dans son dernier livre de vulgarisation, Trous noirs la guerre des savants, fait de l'entropie, la chaleur, l'agitation. Mais selon la seconde loi de la thermo-dynammique n'advient que dans les systèmes isolés (c'est-à-dire qui n'échange ni masse ni énergie seulement de l'information), c'est pourquoi elle va presque toujours croissante. Susskind fait tenir à Boltzmann cette constatation : "l'entropie est de l'information microscopique cachée puisque ce n'est pas toujours que l'entropie augmente" (p. 203). Mais cela est une vision déterministe posée sur le monde qui est avant tout humain c'est-à-dire imprévisible dans ses "erreurs", comprenez ses mutations, ses transformations. C'est précisément que "la vision statistique de Botlzmann sur l'entropie est à la base des sciences pratique de l'information" (ibid.) Les statistiques, post-communardes, sont notamment à l'origine du passage des métiers au professions régies cette fois par l'Etat. .es statistiques sont la marque des limites de la science déterministe en ce que tout ne se laisse pas dénombrer : c'est la puissance de l'indénombrable qui touche à l'énergie, à la puissance de l'indénombrable (vous retrouverez cela dans le plateau sur ou dans le dernier entretien de Paul Virilio, l'administration de la peur). Preuve de l'inefficience des sciences basées sur les statistiques notamment la sociologie à partir de Tarde, réinvestie autrement par Bourdieu c'est que par exemple l'état de phase d'un photon ou tout autre particule quantique est soumise à la probabilité statistique. Cette vision qui consiste à mesurer apparaît comme inepte ou issue d'une pensée de la réalité et non de la complexité puisque nos ordinateur, ce que vous avez sous les yeux fonctionne, lui, de manière non-probabiliste (c'est davantage vous et surtout moi qui risquons de commettre des erreurs mais les électrons coincés dans leur puits quantique (bits) sont codés suivant leur oscillation sur eux-mêmes en 1 ou 0. Vous pourrez même tuer le faux-problème du chat de Schrödinger que vous auriez encore des chances de tout comprendre à la physique quantique.

Si l'entropie est la mesure de la chaleur, de l'agitation des particules, si cette mesure faite par une thermomètre est notée température on peut se dire qu'une approche tout autre que l'approche thermique que nous avons projeté sur le monde à partir de notre peau, pourrait se voir comme l'intensité de l'affectivité. Cette dernière sert de fond primordial à toute volonté de puissance. C'est bel et bien que l'entropie souvent associée au chaos par les philosophes qui se sont penchées sur les lois de la thermodynamique n'existe pas hors des systèmes déterministes physiques.

Peut-être un jour en aura-t-on fini avec ses visions de hasard et de chaos, non qu'il n'y ait que des lois et de l'ordre (cosmos), mais que les premiers (hasard et chaos) découlent de la constation fustrée de l'abscence des seconds (lois et ordre). Signalons que lois et ordre sont avant tout les biais par lesquels la morale et la .politique si'nisune dans la science. Mais c'est poser dès à présent la question de la chaleur d'une société, de l'intensité qui l'anime (nommée par les philosophes affectivité comme "fond primordial" d'activité). La vision de Susskind a en fait tout réduit à la quête d'information et au principe de conservation de celle-ci et non à la création de valeur preuve que la science est décadence dans son aspiration théorique à vouloir dégager les lois qui régiraient le "monde". Mais si ce dernier est agitation perpétuelle et transformations continuelles et si ramené au dépassement de ce qui est proprement humain il produit de la jubilation (comme notes ou tons de l'affectivité) ou de la douleur comme marque d'extension de l'existence, il n'y a pas lie de parler d'entropie.

Différentes questions se posent :

Sur Wiki vous pourrez lire que l'entropie est une fonction d'état. Cela vet dire que sa valeur est déterminée dès que l'état d'équilibre du système est établi. Or si l'entropie est agitation, mouvement aberrant, comment celle-ci pourrait parvenir à un équilibre ?

A propos d'un cours confus sur l'entropie, Susskind se permit cette précision renversante : "Au dire de mon professeur, la température est ce qu'on mesure à l'aide d'un theromomètre" [on en reste à un vague opérationalisme de la mesure]. Définirl'entropie en terme de température, c'est mettre la charrue avant les boeufs. Bien qu'il soit vrai que nous avons tous un sens inné de la température, ce sont les concepts plus abstraits d'énergie et d'entropie qui sont à définir d'abord : le professeur aurait dû par commencer à explmiquer que l'entropie est une mesure de l'information cachée et est exprimée en bits. Il aurait pu ensuite poursuivre en disant correctement : la température est l'accroissement de l'énergie d'un système quand on y ajoute d'un bit d'energie. A strictement parler, c'est la température mesurée à partir du zéro absolu multipliée par la constante de botzmann" (p. 169). Nous avoons définit ce qu'était un bit électronique (binaire), il faut savoir que le bits quantique ne consiste plus à "mesurer" ou interférer avec le sens d'oscillation de l'électron (spin 1/2 ou spin -1/2) mais repérer l'orientation même de cette oscillation (ce qui permet un codage suivant des variations ou ce qui risque d'arriver une densification du codage binaire pour un seul électron prisonnier d'un bit (qui revient à êtrer le puits quantique ou est enfermé l'électron en état d'excitation quantique). C'est là que l'on voit qu'agitation (le pseudo-entropie) et information sont liées. Mais pourquoi cette volonté de mesure et de contrôle de l'agitation ? Nier cet aspect, c'est ne pas connaître cette autre définition que donne Susskind de la dite entropie comme "mesure de l'information cachée - souvent de l'information stockée dans des objets trop petits et nombreux pour qu'on puisse en conserver la connaissance" (ibid. p. 450).

Ces deux questions en gras sont en fait des question de système ou d'établishment (autre nom de la communaté scientifique). On assiste non à des créations mais à des conservations de la vision systèmatique et réductrice.

/https%3A%2F%2Fassets.over-blog.com%2Ft%2Fdelicate%2Fimages%2Fheader%2Fheader.jpg)

/https%3A%2F%2Fwww.ephemanar.net%2Fimages%2Fbateau_guadalquivir_incendie.jpg)

/http%3A%2F%2Fi.ytimg.com%2Fvi%2F5V5cBHKWaXk%2Fhqdefault.jpg)

/https%3A%2F%2Fassets.over-blog.com%2Ft%2Fcedistic%2Fcamera.png)

/https%3A%2F%2Fi.ytimg.com%2Fvi%2FQ6rv9fExoTY%2Fhqdefault.jpg)

/https%3A%2F%2Fi.ytimg.com%2Fvi%2FRrDkovbuWjM%2Fhqdefault.jpg)